Python基于pyCUDA实现GPU加速并行计算功能入门

Python基于pyCUDA实现GPU加速并行计算功能入门

目录

一、简介

在数据科学、机器学习、深度学习和科学计算领域,为了处理大量的数据和复杂的计算,GPU加速已经成为一种常见且有效的手段。pyCUDA是一个可以让Python与CUDA(Compute Unified Device Architecture)进行交互的模块。CUDA是Nvidia GPU上的并行计算架构,使用该架构可以对GPU进行高效运算,以加速Python程序的运行。

本文实例讲述了Python基于pyCUDA实现GPU加速并行计算功能。分享给大家供大家参考,具体如下:

Nvidia的CUDA 架构为我们提供了一种便捷的方式来直接操纵GPU 并进行编程,但是基于 C语言的CUDA实现较为复杂,开发周期较长。而python 作为一门广泛使用的语言,具有 简单易学、语法简单、开发迅速等优点。作为第四种CUDA支持语言,相信python一定会 在高性能计算上有杰出的贡献–pyCUDA。

二、pyCUDA特点

- CUDA完全的python实现

- 编码更为灵活、迅速、自适应调节代码

- 更好的鲁棒性,自动管理目标生命周期和错误检测

- 包含易用的工具包,包括基于GPU的线性代数库、reduction和scan,添加了快速傅里叶变换包和线性代数包LAPACK

- 完整的帮助文档

三、环境准备

在开始之前,需要确保我们的机器上有NVIDIA的GPU,并且安装了CUDA Toolkit。接下来,先安装pyCUDA。可以通过pip轻松安装:

pip install pycuda四、基本概念介绍

- 核函数(Kernel) :在CUDA编程中,核函数是在GPU上并行执行的函数,它由CPU调用并在GPU上执行。

- 线程(Thread) :GPU执行时的基本单位,多个线程可以组成一个线程块。

- 线程块(Block) :线程的集合,所有线程可以协同工作,共享数据和同步执行。

- 网格(Grid) :线程块的集合。

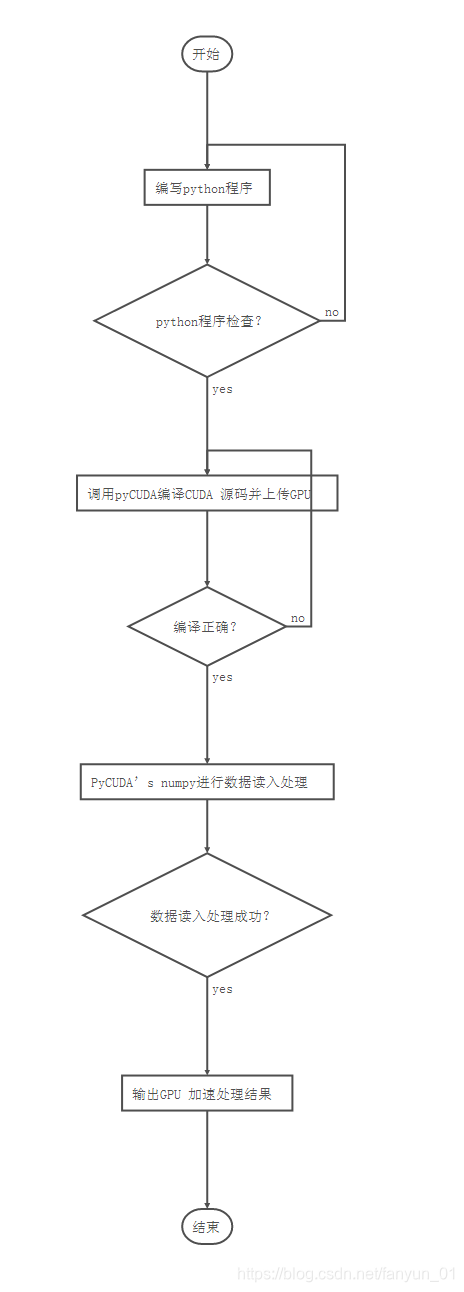

五、pyCUDA的工作流程

具体的调用流程如下:

六、程序示例

第一个pyCUDA程序 假设我们想计算两个大数组的元素级别(element-wise)加法。以下是如何使用pyCUDA来完成这个任务。 首先,导入必要的模块:

import pycuda.autoinit

import pycuda.driver as drv

import numpy

from pycuda.compiler import SourceModulepycuda.autoinit 模块负责初始化 CUDA 设备。 接着,我们需要定义一个 CUDA 核函数,这是 GPU 上执行的函数。在 pyCUDA 中,核函数通常使用 CUDA C 语言编写,并用字符串的形式传递给 SourceModule。

mod = SourceModule("""

**global** void add_kernel(float *d_a, float *d_b, float _d_result, int N)

{

int idx = threadIdx.x + blockDim.x _ blockIdx.x;

if (idx < N)

d_result[idx] = d_a[idx] + d_b[idx];

}

""")这段代码定义了一个简单的核函数 add_kernel,它将两个数组 d_a 和 d_b 的元素相加,并将结果存储在 d_result 中。idx 是每个线程的全局索引,用于计算当前线程应该处理数组中的哪个元素。 现在我们可以从模块中提取核函数,并准备在 GPU 上执行:

add_kernel = mod.get_function("add_kernel")然后,我们创建两个大数组,并初始化它们的值:

N = 1024 \* 1024 # 设定数组大小

a = numpy.random.randn(N).astype(numpy.float32)

b = numpy.random.randn(N).astype(numpy.float32)

result = numpy.zeros_like(a)在将数据发送到 GPU 之前,我们需要将其转换为

numpy

的

float32

类型,因为 CUDA 中默认的浮点数类型是 32 位。

接下来,我们将这些数组传递给核函数,并指定网格和块的大小:

threads_per_block = 256

blocks_per_grid = (N + threads_per_block - 1) // threads_per_block

add_kernel(

drv.In(a), drv.In(b), drv.Out(result), numpy.int32(N),

block=(threads_per_block, 1, 1), grid=(blocks_per_grid, 1))drv.In 和 drv.Out 是 pyCUDA 的辅助函数,用于指定数据传输的方向:从主机到设备或从设备到主机。在这里,我们使用 block 参数来指定每个块的线程数,使用 grid 参数来指定网格的维度。 最后,我们可以检查结果:

print(result[:10]) # 打印前 10 个结果

# 检查 GPU 计算的结果是否正确

if numpy.allclose(result, a + b):

print("Results are correct!")

else:

print("Results are incorrect!")七、具体内容

- 设备交互

- Profiler Control

- 动态编译

- OpenGL 交互

- GPU 数组

- 超编程技术 使用 pyCUDA 在 Python 中进行 GPU 加速计算。通过将核心计算卸载到 GPU 上,我们可以显著提高大规模数组操作的性能。 参考资料: 对于 GPU 加速 python 还有功能包,例如处理图像的 pythonGPU 加速包—— 以及专门的 GPU 加速 python 机器学习包—— Matlab 对应的工具包并行 和 以及 和