VisualC音视频编解码技术与实战手册

Visual++C音视频编解码技术与实战手册

简介:《Visual++C音视频编解码技术及实践》是一份针对使用Microsoft Visual C++程序员的详细文档,涵盖了从基础理论到实际应用的全过程。文档涉及音频和视频的编解码技术,编码理论,解码技术,Visual C++编程实践,实战案例,音视频流处理,性能优化与调试,以及最新的编解码技术趋势。文档不仅为开发者提供了深入理解音视频编解码原理的机会,还通过实际案例帮助他们将理论转化为实战技能,以开发出高质量的音视频应用程序。

1. 音视频基础理论

1.1 音视频信号概念

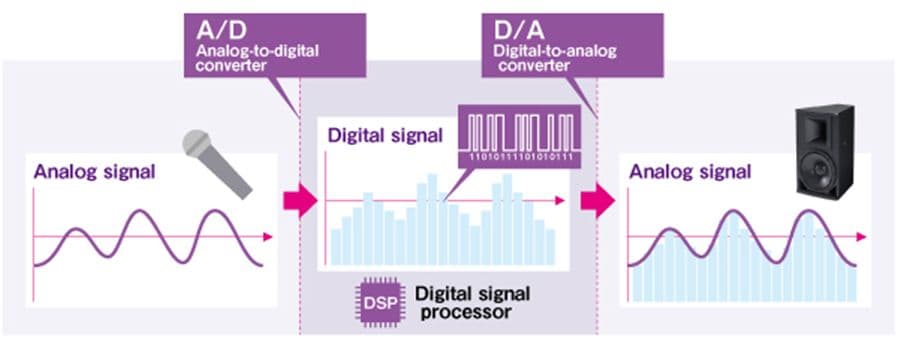

音视频技术是数字媒体的核心,涉及从模拟信号到数字信号的转换,压缩和传输等一系列处理过程。音视频信号的理论基础是理解这些技术的前提。音频信号由声波振动产生,通过频率、振幅和相位三个基本参数来描述。视频信号则通过一系列连续的图像帧来表现动态场景,每一帧都是由像素阵列构成的二维图像。

1.2 数字化过程的重要性

在模拟信号数字化过程中,涉及采样、量化和编码三个关键步骤。采样频率决定了信号数字化后能否重建原信号,依据奈奎斯特定理,采样频率应至少为信号最高频率的两倍。量化则是将采样后的模拟值转换成有限精度的数字值,这一过程会引入量化噪声。数字编码是将量化后的信号转换为二进制码,便于计算机处理。

1.3 压缩技术基础

由于未经压缩的音视频数据量极大,压缩技术不可或缺。压缩分为无损压缩和有损压缩。无损压缩通过数据冗余消除技术,完全保留原始信息,但压缩比有限。有损压缩通过舍弃人耳或人眼不易察觉的信息,来实现更高的压缩率。 MPEG和JPEG等标准就采用有损压缩技术,使得音视频文件体积大幅减小,便于存储和传输,同时也考虑到了压缩对质量的影响。

2. 音视频编解码原理

2.1 音视频数据的数字化过程

2.1.1 模拟信号与数字信号的转换

模拟信号与数字信号的转换是音视频数字化的基础。模拟信号是连续的时间和幅度信号,例如老式的磁带录音和模拟电视信号。而数字信号则是由离散的时间和幅度值组成的信号,这些值通常以二进制形式存储。

在转换过程中,模拟信号首先经过 模数转换器(ADC) ,将模拟信号的连续电压值转换成数字信号的离散值。这个过程涉及到采样、量化和编码三个步骤。采样是按照一定频率将模拟信号的时间连续波形转换成离散的样本值。量化是将样本值转换成有限数目的级别,每个级别用一组二进制数字来表示。编码则是将量化后的样本值转换成二进制数据的过程。

2.1.2 采样理论与压缩技术基础

采样理论中最有名的是 奈奎斯特定理 ,它指出为了能够无失真地重建原始信号,采样频率必须大于信号最高频率的两倍。因此,音频信号的采样频率通常选择44.1 kHz或48 kHz,而视频信号则在24 Hz到60 Hz以上不等。

压缩技术则使得数字信号更加精简,便于存储与传输。无损压缩通过寻找数据中的冗余信息并消除来实现压缩,而有损压缩则通过舍弃一些人类听觉或视觉上不易察觉的信息来实现。在视频中常见的压缩技术有MPEG和H.26x系列,在音频中常见的有MP3、AAC等。

2.2 常用的编解码标准解析

2.2.1 H.264/AVC与H.265/HEVC标准比较

H.264(AVC)和H.265(HEVC)是视频编码领域广泛使用的两个标准。H.265是H.264的后继者,它通过更高效的编码算法来实现更高的压缩比,从而在相同的视频质量下需要的比特率更低。

HEVC的编解码效率大约是AVC的两倍,这使得它能够在4K甚至8K视频的编解码中发挥重要作用。不过,HEVC的编码过程需要更高的计算资源,这在一定程度上限制了它的普及。从压缩效率、编码速度、硬件支持等多个维度来对比这两种标准,可以更深入地理解它们的应用场景和优缺点。

2.2.2 AAC和MP3音频编解码技术

AAC(高级音频编码)和MP3(MPEG-1音频层III)是目前最流行的两种音频压缩格式。MP3在1990年代中期问世,以其较好的压缩率和不错的音质获得了广泛的应用。而AAC是MP3的继任者,由MPEG组织在1997年发布,提供了更好的压缩效率和音质。

相较MP3,AAC能在更低的比特率下提供更高的音质,同时它也支持高达48个声道的多声道音频,而MP3只支持到立体声。AAC的高效性使得它成为许多流媒体服务和数字广播的首选格式。了解这些编解码技术的差异,对于音视频内容的制作、存储和传输至关重要。

2.3 编解码过程中的关键算法

2.3.1 预测编码与变换编码

预测编码是通过参考帧或周围像素来预测当前帧的内容,仅编码预测误差,以此减少数据量。在视频编码中,时间预测和空间预测是最常见的两种类型。变换编码,例如离散余弦变换(DCT),将时域或空间域的信号转换为频域信号,通过去相关的方式减少数据冗余度。

预测编码和变换编码相互结合,大大提高了编码效率。在H.264/AVC和H.265/HEVC中,帧内和帧间预测都是重要的部分,而DCT变换则被用于压缩频域系数,以实现视频数据的高效编码。

2.3.2 熵编码与比特流处理

熵编码是一种无损数据压缩方法,它利用了数据中符号出现频率的差异来减少数据大小。最常用的熵编码方法有Huffman编码和算术编码。Huffman编码通过构造一个最优的二叉树来实现编码,而算术编码则允许对整个符号序列进行编码,可以获得更好的压缩效果,但也更复杂。

比特流处理是指编码后的数据需要按照一定格式组织成比特流,以方便存储或传输。例如,H.264视频数据的比特流结构由序列参数集(SPS)、图像参数集(PPS)、帧内预测模式、运动矢量、变换系数等部分组成,这些都需要编码器按照一定顺序来排列并嵌入相应的语法元素。

以上是第二章的详细内容,它为读者提供了一个全面的了解音视频编解码原理的平台,包括数字化过程、编解码标准以及关键算法,为后续章节深入探讨技术实践和案例分析打下坚实的基础。

3. 编码与解码技术实践

编码与解码技术是数字媒体处理的核心环节,它涉及到将模拟信号转换为数字信号,并通过压缩技术提高传输效率的过程。本章节旨在深入探讨如何使用现有的工具和API进行音视频的编码与解码操作,并实现一个自定义的编解码流程。

3.1 使用FFmpeg进行音视频编码与解码

FFmpeg是一个非常强大的开源多媒体框架,它提供了丰富的命令行工具和API,支持几乎所有的音视频格式和编解码器。本小节将介绍FFmpeg工具的安装与基础使用,为读者搭建起音视频编解码的实践平台。

3.1.1 FFmpeg工具介绍与安装

FFmpeg由一系列的命令行工具组成,核心库libav*(如libavcodec、libavformat等)用于处理音视频数据。它支持几乎所有已知的音视频编码格式,可以用来转码、复用、解复用、流处理、过滤等。

安装FFmpeg前,请确保已经安装了必要的编译工具和依赖库。在大多数Linux发行版中,可以通过包管理器进行安装。例如在Ubuntu上可以使用以下命令:

sudo apt update

sudo apt install ffmpeg对于Windows用户,建议从官网下载预编译的二进制文件,或通过MSYS2进行安装。

3.1.2 使用FFmpeg命令行进行基本编解码操作

FFmpeg的命令行工具可以完成包括转换格式、调整编码参数、截取音视频片段等多种操作。下面是一个简单的例子,将一个MP4文件转换为更通用的avi格式。

ffmpeg -i input.mp4 -c:v libx264 -c:a aac output.avi这条命令解释如下:

-i input.mp4- 输入文件名为input.mp4。

-c:v libx264- 视频编码器选择libx264,即H.264编码。

-c:a aac- 音频编码器选择AAC。

output.avi- 输出文件名为output.avi。

FFmpeg的参数非常丰富,你可以调整分辨率、帧率、码率等,来满足特定的编码需求。

3.2 通过API实现自定义编解码流程

虽然FFmpeg的命令行工具功能强大,但在许多应用场景下,开发者需要在应用程序中集成编解码功能,这时就需要用到FFmpeg提供的API。

3.2.1 X264和FFmpeg库的集成与使用

X264是FFmpeg中常用的H.264视频编码器,其提供的API可以用于编码视频数据。在自定义应用程序中集成X264,需要进行相应的配置和编码初始化。

下面是一个使用libx264进行视频编码的简单示例代码:

#include <libavcodec/avcodec.h>

#include <libavformat/avformat.h>

int main(int argc, char* argv[]) {

AVCodec *codec;

AVCodecContext *c= NULL;

int i, ret, x, y;

av_register_all();

// Find the x264 encoder.

codec = avcodec_find_encoder(AV_CODEC_ID_H264);

if (!codec) {

fprintf(stderr, "Codec not found\n");

exit(1);

}

c = avcodec_alloc_context3(codec);

if (!c) {

fprintf(stderr, "Could not allocate video codec context\n");

exit(1);

}

// Open codec

if (avcodec_open2(c, codec, NULL) < 0) {

fprintf(stderr, "Could not open codec\n");

exit(1);

}

// Allocate and init a re-usable frame

AVFrame *frame = av_frame_alloc();

// ... (省略帧初始化、像素数据填充等步骤)

// encode one video frame

AVPacket pkt;

av_init_packet(&pkt);

pkt.data = NULL; // packet data will be allocated by the encoder

pkt.size = 0;

ret = avcodec_encode_video2(c, &pkt, frame, &got_packet);

if (ret < 0) {

fprintf(stderr, "Error encoding video frame\n");

exit(1);

}

// pkt now contains the encoded frame

av_frame_free(&frame);

avcodec_close(c);

avformat_free_context(c);

return 0;

}在这段代码中,我们首先注册所有的编解码器,接着查找并初始化 libx264 编码器。随后进行了一系列的配置和编码操作。最后释放了所有分配的资源。

3.2.2 编码器与解码器的初始化与配置

编码器和解码器的初始化是编解码过程中的重要一环。在初始化时,我们设置编码器或解码器的相关参数,如视频尺寸、帧率、比特率、关键帧间隔等,以满足特定应用的需求。

下面是一个示例,展示如何配置编码器的相关参数:

// 配置编码器参数

c->width = 1920; // 视频宽度

c->height = 1080; // 视频高度

c->time_base = (AVRational){1,25}; // 帧率 25fps

c->framerate = (AVRational){25,1}; // 同样设置为 25fps

c->pix_fmt = AV_PIX_FMT_YUV420P; // 使用 YUV 4:2:0 格式

c->bit_rate = 400000; // 设置比特率为 400kbps

// 如果需要,还可以设置编码器选项

av_dict_set(&opts, "preset", "ultrafast", 0);

// 打开编码器

if (avcodec_open2(c, codec, &opts) < 0) {

fprintf(stderr, "Could not open codec\n");

exit(1);

}通过精心配置编解码器参数,可以获得更好的编码效率和输出视频质量。这通常需要根据应用场景和具体需求进行细致的调整。

通过本章节的介绍,我们详细讨论了如何使用 FFmpeg 工具进行音视频编解码操作,并通过示例展示了如何在应用程序中集成 FFmpeg 和 X264 库,实现自定义的编解码流程。在接下来的章节中,我们将介绍在 Visual C++环境下进行音视频编程的方法和技巧。

4. Visual C++音视频编程

在本章节中,我们将探讨如何利用 Visual C++进行音视频编程。Visual C++是微软提供的一个功能强大的开发环境,它支持多种音视频处理技术。通过本章的学习,读者将能够理解如何在 Visual C++环境下设置开发环境、选择合适的组件以及实现音视频文件的处理和播放。

4.1 Visual C++环境下的开发准备

4.1.1 开发环境搭建与配置

在开始音视频处理编程之前,需要确保 Visual C++的开发环境已经搭建并配置完成。这涉及到安装 Visual Studio,选择合适的开发工具集,以及设置 C++编译器和链接器参数。在安装 Visual Studio 时,推荐选择支持 C++的最新版,以及安装 C++桌面开发相关的工作负载。此外,根据项目需要,可能还需要安装 DirectX SDK,这是处理音视频数据时常用的库之一。

flowchart LR

A[开始] --> B[下载并安装 Visual Studio]

B --> C[启动 Visual Studio 安装器]

C --> D[选择工作负载]

D -->|选择 C++桌面开发| E[安装 C++编译器和相关工具]

E --> F[可选:安装 DirectX SDK]

F --> G[完成安装与配置]

G --> H[环境准备完毕]4.1.2 MFC 框架与音视频处理组件选择

选择合适的框架和组件是编程的另一关键步骤。MFC(Microsoft Foundation Classes)是一个为 Windows 应用程序提供的编程接口。在处理音视频时,可以使用 MFC 中的 ActiveX 控件,比如 AxWindowsMediaPlayer,来实现文件的播放功能。此外,为进行更深层次的音视频处理,可以考虑使用 DirectShow 框架,它是 Windows 平台下强大的媒体处理框架,提供了丰富的接口用于捕获、处理和渲染音视频数据。

graph LR

A[选择 MFC 框架与音视频处理组件]

A --> B[使用 MFC 进行界面开发]

A --> C[集成 ActiveX 控件]

A --> D[使用 DirectShow 进行媒体处理]4.2 音视频文件的处理与播放

4.2.1 文件读取与解码流程实现

在 Visual C++中处理音视频文件,首先需要读取文件中的数据,然后进行解码,最终转换为可用的音频和视频数据。这一过程涉及到文件 I/O 操作,以及对音视频数据的解码。使用 DirectShow 可以简化这一流程。以下是使用 DirectShow 读取和解码视频文件的基本步骤:

- 创建并初始化 Filter Graph Manager。

- 添加 Source Filter,用于读取文件。

- 添加解码 Filter,将压缩的音视频数据解码成原始数据。

- 连接各个 Filter,并启动播放。

// 示例代码:初始化 DirectShow Filter Graph

#include <dshow.h>

#pragma comment(lib, "strmiids.lib")

// CoInitialize 初始化 COM 库。

HRESULT hr = CoInitialize(NULL);

if (SUCCEEDED(hr))

{

// 创建 Filter Graph Manager

IGraphBuilder *pGraph = NULL;

hr = CoCreateInstance(CLSID_FilterGraph, NULL, CLSCTX_INPROC_SERVER, IID_IGraphBuilder, (void **)&pGraph);

if (SUCCEEDED(hr))

{

// 此处添加后续的 DirectShow 操作代码...

}

// 释放资源

pGraph->Release();

}

CoUninitialize();4.2.2 音视频同步与播放控制

音视频同步是实现流畅播放的关键。在 Visual C++中,需要确保音频和视频流在播放时保持同步,避免出现声音和画面不同步的问题。DirectShow 提供了一套机制来解决这一问题,例如使用参考时钟(Reference Clock)来同步不同流的播放。播放控制则涉及到了暂停、继续播放、停止等操作。

// 示例代码:控制 DirectShow Filter Graph 播放

IAMMediaControl *pControl = NULL;

hr = pGraph->QueryInterface(IID_IAMMediaControl, (void **)&pControl);

if (SUCCEEDED(hr))

{

// 开始播放

pControl->Run();

// 暂停播放

pControl->Pause();

// 继续播放

pControl->Run();

// 停止播放

pControl->Stop();

pControl->Release();

}在本章节中,我们探索了 Visual C++环境下的开发准备,包括搭建开发环境和选择合适的框架与组件。同时,我们了解了如何实现音视频文件的处理与播放,以及音视频同步和播放控制的方法。通过上述内容的学习,读者应该具备了在 Visual C++环境下进行基本音视频编程的能力。

5. 实际音视频编解码案例

5.1 实时视频捕获与编码

5.1.1 利用 DirectShow 进行视频捕获

视频捕获是实时视频处理的第一步,DirectShow 是微软提供的一套用于处理流媒体的开发工具包。DirectShow 通过 Filter Graph 管理媒体数据流的处理,每个 Filter 负责数据流的一个处理步骤。为了实现视频捕获,首先需要构建一个包含视频捕获设备的 Filter Graph。

在构建 Filter Graph 时,典型的步骤包括:

- 加载并枚举系统中的视频捕获设备。

- 创建和配置视频源 Filter(通常是一个捕获设备的 Filter)。

- 添加视频处理 Filter,如视频编码器,以便输出压缩的视频流。

- 连接所有 Filter 以确保数据可以流过整个 Graph。

下面的代码示例演示了如何使用 DirectShow 的 COM 接口创建一个简单的视频捕获 Filter Graph:

#include <dshow.h>

#pragma comment(lib, "strmiids.lib")

int main(int argc, char* argv[])

{

HRESULT hr = CoInitializeEx(NULL, COINIT_APARTMENTTHREADED);

if (SUCCEEDED(hr))

{

IGraphBuilder *pGraph = NULL;

IMediaControl *pControl = NULL;

IMediaEvent *pEvent = NULL;

// 创建 Filter Graph Manager

hr = CoCreateInstance(CLSID_FilterGraph, NULL, CLSCTX_INPROC_SERVER, IID_IGraphBuilder, (void **)&pGraph);

if (SUCCEEDED(hr))

{

// 获取媒体控制和事件接口

hr = pGraph->QueryInterface(IID_IMediaControl, (void**)&pControl);

hr = pGraph->QueryInterface(IID_IMediaEvent, (void**)&pEvent);

// 构建 Filter Graph

// ...

}

}

// Clean up COM objects

if (pGraph) pGraph->Release();

if (pControl) pControl->Release();

if (pEvent) pEvent->Release();

CoUninitialize();

return 0;

}在构建 Filter Graph 之后,需要通过 IMediaControl 接口调用 Run 方法来启动视频流捕获。此外,IMediaEvent 接口用于处理事件,比如用户停止捕获或者 Filter Graph 出错。

5.1.2 实时视频流的编码与发送

编码视频流是为了减少数据大小和满足网络传输的需要。在 DirectShow 中,可以通过添加编码器 Filter 到 Filter Graph 中完成编码工作。同时,要发送编码后的实时视频流,通常会使用 RTP 协议或 HTTP 直播流(HLS)。

使用 DirectShow 完成视频编码和发送的步骤可以概括为:

- 选择合适的视频编码 Filter,例如 H.264 编码 Filter。

- 将编码 Filter 添加到 Filter Graph 中,并确保它与视频源 Filter 和输出 Filter 正确连接。

- 设置编码参数,例如分辨率、帧率和比特率。

- 通过一个网络传输 Filter,如 File Writer Filter,将编码后的流发送到网络。

代码片段示例:

// 假设 pControl 已经初始化并且 Filter Graph 已经构建完成

hr = pControl->RenderFile(L"output_file.mp4");

if (SUCCEEDED(hr))

{

// 启动流处理

hr = pControl->Run();

}在发送实时视频流时,服务器端可能需要同时运行一个网络服务,比如使用 Windows Media Services 或者开源 RTMP 服务器,将编码后的视频流转换为适合网络传输的格式。

接下来,我们会进一步探讨高级音视频处理功能的实现。在这些实现中,我们不仅要注重音视频质量的优化,还要确保处理后的音视频数据能够满足实际应用中的特定需求。

6. 音视频流处理技术

在现代的互联网应用中,音视频流处理技术扮演了至关重要的角色。随着网络速度的提升和多媒体应用的普及,如何高效、稳定地传输和存储音视频流成为了技术开发人员必须面对的挑战。本章将深入探讨音视频流的传输与同步、存储与点播技术,为读者提供在实际项目中应用这些技术的指导。

6.1 音视频流的传输与同步

音视频流在进行网络传输时,面临着丢包、延迟和带宽波动等网络问题。要实现高质量的音视频流服务,必须通过有效的协议和机制来保证传输的稳定性和同步。

6.1.1 RTP/RTCP 协议在流媒体中的应用

实时传输协议(RTP)和实时控制协议(RTCP)是音视频流媒体传输中广泛使用的一对协议。RTP 负责数据包的传输,而 RTCP 则负责监控服务质量和传输统计信息。

- RTP 协议 :RTP 通过为每个媒体流分配一个唯一的端口号和序列号,保证音视频数据包按顺序正确地到达目的地。序列号还可以用来检测丢包和重复。

- RTCP 协议 :RTCP 周期性地发送控制数据包,提供诸如传输质量的反馈、参与者统计信息和同步信息。这些信息对于维护音视频流的质量至关重要。

6.1.2 实现音视频流的网络传输与同步机制

音视频流的同步是指在接收端同步处理音频和视频数据流,以保证它们以正确的顺序和时间间隔播放。实现同步的关键在于:

- 时间戳 :在音视频数据包中嵌入时间戳信息,确保在播放时可以按照正确的时序输出。

- 缓冲管理 :使用适当的缓冲策略来应对网络延迟和抖动,保证数据包不会因为网络问题而过早或过晚地播放。

- 同步算法 :利用时间戳和缓冲区的状态信息,开发同步算法以处理音视频流的异步到达问题。

// 示例代码:RTP 包头的简化表示

struct RTP_Packet {

uint8_t version;

uint8_t padding;

uint8_t extension;

uint8_t cc;

uint8_t marker;

uint8_t payloadType;

uint16_t sequenceNumber;

uint32_t timestamp;

uint32_t ssrc;

// 数据负载部分略

};6.2 音视频流的存储与点播技术

除了实时传输之外,音视频流的存储和点播技术也非常重要。为了支持在线点播和视频回放服务,需要对音视频流进行有效的存储和管理。

6.2.1 流媒体文件格式与存储策略

选择合适的流媒体文件格式是实现高效存储的关键。当前流行的格式有 MP4、FLV 和 WebM 等。每种格式都有自己的编码方式、封装结构和元数据信息。选择合适的格式能够减少存储空间的浪费,并提高数据访问效率。

- 元数据管理 :元数据描述了音视频流的属性,如持续时间、分辨率、编码方式等,是实现高效检索和管理的基础。

- 存储策略 :存储策略需要考虑到数据的冗余、备份、分布式存储等因素。分布式存储技术如对象存储和分布式文件系统可以提高系统的可靠性和扩展性。

6.2.2 点播服务的搭建与优化

点播服务允许用户根据自己的需求选择和播放音视频内容。搭建一个高效的点播服务需要关注以下几个方面:

- 内容分发网络(CDN) :利用 CDN 技术可以将内容缓存到用户附近的服务器上,减少延迟,提高播放速度。

- 协议支持 :除了 HTTP,支持如 HLS 和 DASH 等流媒体协议,可以为用户提供更加平滑的播放体验。

- 服务质量(QoS) :通过分析用户行为和网络状况,动态调整视频质量,确保在各种网络条件下提供最佳的观看体验。

graph LR

A[用户请求] -->|获取用户信息和网络状况| B[内容分发策略]

B -->|选择最佳服务器| C[CDN 节点]

C -->|提供视频流| D[用户端]在以上章节中,我们从音视频流的网络传输和同步,到存储与点播技术进行了深入探讨。每节内容都是围绕着实际操作和应用场景展开,不仅提供了理论知识,还附上了示例代码和流程图,力求为读者提供完整的学习和参考路径。希望读者能从这些章节中获得有价值的见解和启发。

简介:《Visual++C 音视频编解码技术及实践》是一份针对使用 Microsoft Visual C++程序员的详细文档,涵盖了从基础理论到实际应用的全过程。文档涉及音频和视频的编解码技术,编码理论,解码技术,Visual C++编程实践,实战案例,音视频流处理,性能优化与调试,以及最新的编解码技术趋势。文档不仅为开发者提供了深入理解音视频编解码原理的机会,还通过实际案例帮助他们将理论转化为实战技能,以开发出高质量的音视频应用程序。