X-CLIP和X-FLORENCE论文解读

X-CLIP和X-FLORENCE论文解读

1.研究背景

尽管已有研究探索了如何将语言-图像模型迁移到其他下游任务(如点云理解和密集预测),但视频识别领域的迁移和适应性研究还不够充分。例如,ActionCLIP提出了一种“预训练、提示和微调”的框架用于动作识别,但这种方法仅针对特定任务,且没有充分利用视频的时间信息。此外,现有的视频Transformer方法( 如ViViT和VTN )虽然在视频识别中取得了不错的效果,但它们要么计算成本高,要么在利用时间信息方面存在不足。 本文提出了一种简单而有效的方法,能够直接将预训练的语言-图像模型适应于视频识别,而不是从头开始预训练一个新的模型。作者通过引入一种跨帧注意力机制(cross-frame attention mechanism)来捕捉帧之间的时间依赖性,并设计了一种视频特定的提示方案(video-specific prompting scheme),利用视频内容信息生成区分性的文本提示

2.创新点

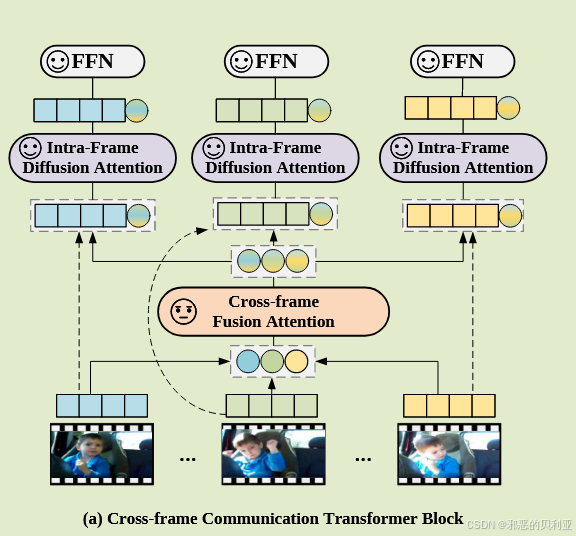

2.1跨帧注意力机制(Cross-Frame Attention Mechanism)

跨帧融合注意力(CFA)

CFA 的作用是允许帧之间直接交换信息。具体来说:

跨帧融合注意力(CFA)

CFA 的作用是允许帧之间直接交换信息。具体来说:

- 每个帧都有一个 消息令牌(message token) ,用于抽象当前帧的视觉信息。

- 这些消息令牌会参与到全局的时间依赖性建模中。

- 消息令牌的计算方式如下:

为t帧在l层的消息令牌 w是一个线性矩阵,

是前一层的特征输出。 所有帧的消息令牌会参与到跨帧融合注意力中

CFA 是一个自注意力模块,它允许消息令牌之间相互作用,从而捕捉帧之间的时间依赖性

帧内融合注意力(IFA)

IFA 的作用是在帧内传播全局的时间信息,增强帧的表示能力

- 其中,

是帧特征的更新表示, m ˉ t ( l ) 是消息令牌的更新表示。

- 消息令牌在每个块中仅用于信息交换,不会传递到下一个块。

2.2 视频特定提示

(1) 视觉特征的提取

首先,从视频中提取视觉特征。这些特征可以是视频帧的特征,也可以是视频的整体特征。视觉特征的提取通常使用预训练的视觉模型(如 CLIP 的视觉编码器)来完成。

(2) 文本特征的初始化

文本特征可以是类别标签的嵌入,也可以是其他与任务相关的文本信息。这些文本特征将作为提示的初始输入。

(3) 跨模态交互

通过跨模态交互(cross-modal interaction),将文本特征与视觉特征进行融合。具体来说,使用多头注意力机制(cross-attention)让文本特征“看到”视觉特征,从而生成与视频内容相关的提示。这个过程可以描述为:

- Query (Q)

:文本特征(

text)。 - Key (K) 和 Value (V) :视觉特征(visual) 通过多头注意力机制,文本特征会根据视觉特征的上下文进行更新,生成更具体的提示。

(4) 多层提示生成

为了进一步增强提示的表达能力,可以使用多层提示生成器。每一层都会对文本特征进行更新,使其逐渐融入更多的视觉信息。这个过程可以描述为:

- 归一化 :对视觉特征进行归一化处理,以稳定训练。

- 跨模态注意力 :通过多头注意力机制,将文本特征与视觉特征进行交互。

- MLP :使用多层感知机进一步增强文本特征。

- 残差连接 :将更新后的文本特征与原始文本特征相加,实现残差连接。

(5) 可学习的权重

为了调整生成的提示的强度,可以引入一个可学习的权重(

alpha

)。这个权重可以控制提示对最终输出的影响程度。

3. 实验结果

作者在多个视频识别数据集上进行了广泛的实验,验证了方法的有效性。以下是主要结果的总结:

(1) 全监督学习(Fully-Supervised Learning)

在全监督学习设置下,作者的方法在 Kinetics-400 和 Kinetics-600 数据集上取得了显著的性能提升:

- Kinetics-400 :

- X-CLIP-L/14 :达到了 87.1% 的 top-1 准确率,比现有的 ViViT-H 模型高出 2.3%,同时计算量(FLOPs)减少了 12 倍。

- Kinetics-600 :

- X-CLIP-L/14 :达到了 88.3% 的 top-1 准确率,比现有的 MTV-H 模型高出 2.5%,同时计算量减少了 5 倍。 这些结果表明,作者的方法在保持高效计算的同时,能够显著提升视频分类的性能。

(2) 零样本学习(Zero-Shot Learning)

在零样本学习设置下,作者的方法在 HMDB-51 和 UCF-101 数据集上取得了显著的性能提升:

- HMDB-51 :

- X-Florence :达到了 48.4% 的 top-1 准确率,比现有的 ActionCLIP 方法高出 7.6%。

- UCF-101 :

- X-Florence :达到了 73.2% 的 top-1 准确率,比现有的 ActionCLIP 方法高出 14.9%。 这些结果表明,作者的方法在零样本学习场景下具有更强的泛化能力。

(3) 少样本学习(Few-Shot Learning)

在少样本学习设置下,作者的方法在 HMDB-51 和 UCF-101 数据集上取得了显著的性能提升:

- HMDB-51 (2-shot):

- X-Florence :达到了 51.6% 的 top-1 准确率,比现有的方法高出 30.7%。

- UCF-101 (2-shot):

- X-Florence :达到了 84.0% 的 top-1 准确率,比现有的方法高出 30.7%。 这些结果表明,作者的方法在少样本学习场景下能够更好地利用有限的数据进行学习。

4.总结(不足和前景)

在论文《Expanding Language-Image Pretrained Models for General Video Recognition》中,作者提出的 X-Florence 模型通过将预训练的语言-图像模型(如 Florence)扩展到视频领域,显著提升了视频识别任务的性能。然而,尽管 X-Florence 在多个数据集上取得了令人瞩目的成果,仍存在一些需要进一步优化的方面。例如,跨帧注意力机制虽然能够有效捕捉帧之间的时空依赖关系,但其计算复杂度较高,尤其是在处理长视频时,这可能会限制模型在实际应用中的效率。此外,X-Florence 对大规模预训练数据的依赖性较强,获取足够规模和多样性的视频-文本对数据可能存在挑战,这可能会影响模型在特定领域的泛化能力。模型的复杂架构也带来了训练难度和调优成本的增加,这在实际部署时可能会成为一个瓶颈。最后,尽管视频特定提示(video-specific prompts)增强了模型对视频内容的理解,但在处理复杂场景和动作时,模型的语义理解能力仍有提升空间。 展望未来,X-Florence 的改进方向十分明确且具有广阔的应用前景。首先,提升计算效率是一个关键的研究方向。例如,可以引入稀疏注意力机制来降低计算开销,同时保持对时空依赖关系的捕捉能力;此外,模型压缩技术(如量化和剪枝)也能够优化模型的计算效率,使其更适合在资源受限的环境中运行。其次,减少对大规模预训练数据的依赖是另一个重要的研究方向。通过数据增强技术(如视频帧的随机采样、裁剪和翻转)来扩充训练数据,以及利用自监督学习方法(如对比学习)来减少对标注数据的依赖,可以显著提升模型的泛化能力,使其在更多领域和任务中表现出色。此外,进一步优化模型架构也是提升性能的关键。例如,采用模块化设计可以使模型在不同任务中更加灵活地调整;而多任务学习框架则能够使模型同时处理多种视频任务(如分类、描述生成和问答),从而提升其综合性能。同时,增强模型的语义理解能力也是未来的研究重点。开发更灵活的提示生成机制,能够根据视频内容动态调整提示,从而更好地适应不同类型的视频内容;进一步融合语言、视觉和其他模态(如音频)的信息,将显著增强模型对视频内容的全面理解能力。最后,X-Florence 的应用前景广阔。除了视频分类任务外,模型还可以应用于视频描述生成、视频问答以及医学视频分析等领域,为视频理解及相关应用带来新的突破。 综上所述,尽管 X-Florence 在视频识别任务中取得了显著的成果,但仍存在一些不足之处,如计算效率、数据依赖性、模型复杂性和语义理解能力等方面。未来的研究可以通过优化计算效率、改进数据处理方法、优化模型架构、增强语义理解能力以及拓展模型在更多视频任务中的应用来进一步提升模型的性能和泛化能力,使其在视频理解及相关领域发挥更大的作用。